המפתח לחלק מהאופטימיזציה שלכם באתר הוא ה- אז מהו קובץ רובוט.טקסט. / robots.txt.file?

🚀 קחו את העסק שלכם לשלב הבא עם רובוט.טקסט

השאירו פרטים וקבלו ייעוץ חינם עבור שירותי רובוט.טקסט!

קובץ רובוט.טקסט הוא קובץ אשר לעתים קרובות מתעלמים ממנו, המלצה שלי היא כי הדבר חיוני בהתחייס לתקשורת בין אתר למנועי חיפוש. קובץ זה לבדו יכול להיות יותר מכמה בתים ולכן כדאי לכלול אותו באסטרטגיית האופטימיזציה שלכם.

לרוב ניתן למצוא את קובץ robots.txt בספריית ה-ROOT של האתר ומטרתו לווסת את הרובוטים הסורקים את האתר שלכם. כאן אתם בעצם מעניקים או שוללים הרשאה לכל הרובוטים או לרובוטים מסוימים של מנועי חיפוש לגשת לדפים מסוימים, או לאתר שלכם בכללותו.

ההיסטוריה של קובץ הרובוט.טקסט

ה'robots.txt.file פותח בשנת 1994, הוא מכונה תקן / פרוטוקול לאי הכללת רובוטים.

מידע נוסף כאן: robotstxt

החוקים של קובץ רובוט.טקסט. – Robots.txt. RULES

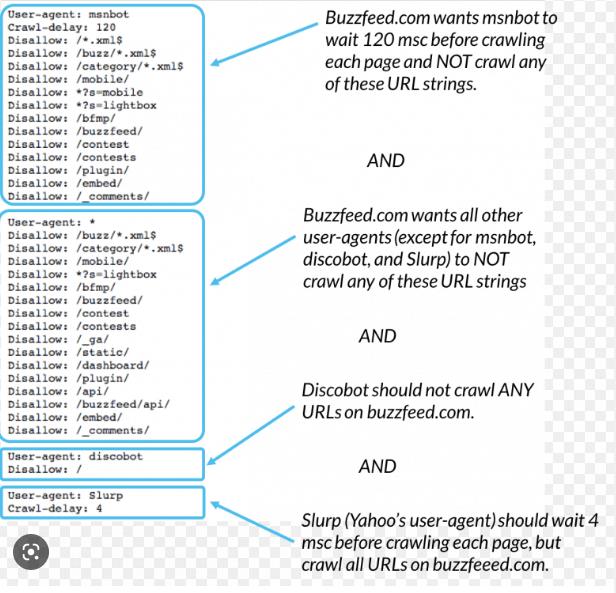

לרובוט טקסט יש השפעה גדולה מאוד על תהליך קידום אתרים אורגני באתר שלכם, הכללים של תקן אי הכללת הרובוטים רופפים ואין גוף רשמי השולט בכך. ישנם אלמנטים נפוצים המפורטים להלן:

- User-agent: הכוונה היא לבוטים הספציפיים שהכללים חלים על

- Disallow בהתייחס לאזורי האתר שהבוט שצוין על ידי user-agent אינו אמור לסרוק.

- אפשר: משמש במקום או בתוך בנוסף לאמור לעיל, עם משמעות הפוכה. קובץ

ה- robots.txt. לעיתים קרובות מזכיר את המיקום של מפת האתר ולמרות שרוב הרובוטים החיפוש הקיימים – כולל אלה השייכים למנועי החיפוש העיקריים – מתרגמים ומבינים את האלמנטים הנ"ל, לא כולם נצמדים ל חוקים! כמו גם בכל דבר, מקרים מסוימים שאינם נופלים מכך:

אמנם " גוגל לא תסרוק או תוסיף אינדקס לתוכן הדפים שנחסמו על ידי robots.txt, אך אנו עשויים עדיין להוסיף את כתובות האתרים לאינדקס אם אנו מוצאים אותן בדפים אחרים באינטרנט. כתוצאה מכך, כתובת האתר של הדף וייתכן שמידע אחר זמין לציבור, כגון טקסט עוגן בקישורים לאתר, או הכותרת מפרוייקט Directory Directory (www.dmoz.org), יכולים להופיע בתוצאות החיפוש של גוגל. ”

זה מצביע על כך שגוגל עדיין יכולה להוסיף לאינדקס דפים אחרים, גם אם הם חסומים ב- robots.txt.file. להלן הקישור לתמיכה של Google ומדריך, וכן הוראות כיצד לחלק.

מהו קובץ רובוט.טקסט במילים של גוגל עצמה

מבנה קובץ ה robots.txt.file

הבה נבחן מבנה קבצים אופייני להתחלה:

User-agent: *

Disallow:

Sitemap: https:// / /www.yoursite.com/sitemap.xmlUser-agent: *

Disallow:

Sitemap: https:// / /www.yoursite.com/sitemap.xmlהדוגמה המוצגת פירושה כי:

- כל בוט יכול לגשת לכל דבר באתר וה-

- sitemap נמצא בכתובת .

- התו הכללי (*) פירושו שהכלל חל על כלרובוטים

כללי הגישה של

כדי להגדיר כללי גישה לרובוט ספציפי, למשל Googlebot, יש להגדיר את סוכן המשתמשים בהתאם:

- User-agent: Googlebot

- Disallow: / images /

User-agent: Googlebot

Disallow: / images /לעיל לדוגמא, Googlebot מסורבת גישה לתיקיה / תמונות / לאתר. בנוסף, ניתן להגדיר כלל ספציפי שיאסור במפורש גישה לכל הקבצים שבתיקיה:

- Disallow: / images / *

התו הכללי במקרה זה מתייחס לכל הקבצים שבתיקיה. אבל robots.txt יכול להיות גמיש עוד יותר ולהגדיר כללי גישה לדף ספציפי:

- Disallow: /blog/readme.txt

– או סוג קובץ מסוים:

- Disallow: / content / *. Pdf

אם אתר משתמש בפרמטרים בכתובות אתרים וכתוצאה מכך בדפים עם תוכן כפול ניתן לבטל את הסכמתם להוסיף אותם לאינדקס באמצעות כלל מתאים, משהו כמו: לא

- לאפשר: / *? *

האמור לעיל לא לסרוק כתובות אתרים עם '?' בהם וזו לעתים קרובות הדרך בה אתה רואה פרמטרים הכלולים בכתובות אתרים.

עם קבוצה כה נרחבת של פקודות קל לראות שזה יכול להיות מסובך גם לבעלי אתרים וגם למנהלי אתרים כאחד וכיצד נעשות טעויות, שעלולות להיות יקרות.

טעויות נפוצות של robots.txt:

יש כמה טעויות שקל לזהות והן מפורטות להלן כמה מהכי נפוצות

- אין קובץ robots.txt בכלל

- ללא קובץ robots.txt עבור האתר שלכם – פירושו שהוא פתוח לחלוטין עבור כל עכביש לזחול. אם יש לכם אתר סטטי פשוט עם עמודים מינימליים ושום דבר שאתם רוצים להסתיר, יתכן שזו לא בעיה, אך סביר להניח שאתם מפעילים CMS (מערכת ניהול תוכן) אז רצוי שתבדקו זאת לעומק. אין CMS מושלם, ורוב הסיכויים שיש מקרים הניתנים לאינדקס של תוכן כפול בגלל שאותם מאמרים נגישים באמצעות כתובות אתרים שונות, כמו גם דברים backend שאינם מיועדים למבקרים באתר.

- קובץ רובוט.טקסט ריק.

זה יכול להיות גם בעייתי וכמו כן לכלול את הנושאים שלעיל, בהתאם ל- CMS המשמש באתר, בשני המקרים יש גם סיכון לכך שכתובות אתרים כמו הדוגמה הבאה יוסיפו לאינדקס:

- https:// //www.somedomain. com / srgoogle /? utm_source = google & utm_content =% 20bad% 20 מפתח כלשהו & utm_term = & utm_campaign …

זה יכול לחשוף את האתר שלך לאינדקס בהקשר של סביבת אחסון דומיין גרועה. (שם הדומיין האמיתי הוחלף כמובן, אך הדומיין שבו סוג זה של כתובות אתרים הניתנים לאינדקס היה בעל קובץ robots.txt ריק)

ברירת מחדל של robots.txt המאפשרת גישה לכל מה

שקובץ Robots.txt מראה כמו בדוגמה הבאה:

- משתמש- סוכן: *

- אפשר: /

- או ככה:

- סוכן משתמש: *

אסור

כמו בשני המקרים הקודמים, אתה עוזב את האתר שלך לגמרי לא מוגן ואין טעם שיהיה לך קובץ robots.txt כזה בכלל, אלא אם כן, שוב , אתה מפעיל דף מינימלי סטטי ולא רוצה להסתיר שום דבר בשרת.

איך יוצרים קובץ רובוט.טקסט?

צפו בסרטון הבא ולמדו כיצד ניתן ליצור קובץ robots.txt.file בפחוט מדקה.

איזה שיטה הכי טובה לקובץ רובוט.טקסט?

השיטה הטובה ביותר היא לא להטעות את מנועי החיפוש, אם קובץ ה- sitemap.xml שלך מכיל כתובות אתרים שנחסמו במפורש על ידי robots.txt שלך, זו סתירה. זה יכול לקרות לעתים קרובות אם הקבצים שלך robots.txt ו / או sitemap.xml נוצרים על ידי כלים אוטומטיים שונים ולא נבדקים ידנית לאחר מכן.

קל לראות זאת באמצעות כלי מנהלי האתרים של גוגל. לשם כך תצטרך להוסיף את האתר שלך לכלי מנהלי האתרים של גוגל, לאמת אותו ולהגיש לו מפת Sitemap של XML. מכאן תוכל לראות דוח על סריקת כתובות האתרים שנשלחו באמצעות מפת האתר בקטע אופטימיזציה> Sitemaps בכלי מנהלי האתרים של גוגל.

חסימת גישה לאזורים רגישים באמצעות robots.txt

אם ישנם אזורים באתר שלך שדורשים חסימה, הגן עליהם באמצעות סיסמה. אל תעשה זאת עם robots.txt.

כזכור ש- robots.txt הוא המלצה, ולא סט חוקים חובה שמשמעותו שמי שלא עוקב אחר הפרוטוקול עדיין יכול לגשת לאזור כמו גם בוטים נוכלים. כלל האצבע הטוב ביותר הוא שאם הוא צריך להיות פרטי ב 100%, עדיף לא לשים אותו ברשת! זה היה ידוע כי קהילת ה- SEO גילתה פרויקטים שטרם פורסמו לציבור מ- Google על ידי התבוננות ב- robots.txt.

בעוד שיש לקחת בחשבון הרבה עם robots.txt וזה חלק מרכזי באופטימיזציה שלך, אנו מקווים כי זה שימושי כאשר בוחנים את הדרך הטובה ביותר לפעולה. עדיין יש קצת כיף לעשות עם robots.txt אולם, ולמבט קליל יותר על זה, הקישור למטה מספק קריאה נהדרת!

דוגמאות לקבצי רובוט טקס מושלמים

בהתאמה למה שאתם רוצים להשיג באמצעות קריאה ואינדוקס של האתר שלכם, תוכלו לקנפג ולהגדיר פרוטוקולים בקובץ הרובוט טקס עצמו.

תוכלו לבצע את הפעולות הבאות:

חסימת רובוטים שונים, קרולרים של מנועי חיפוש וכל מני רובוטים המבצעים סקרייפינג אוטומטי לאתרים, news jack's ו- פידים של rss.

אני מומחה לקידום אתרים הוליסטי והפאן הטכני וזו האהבה שלי, אם אתם צריכים עזרה עם קובץ הרובוט.טקסט שלכם או בכל נושא הקשור לקידום אתרים טכני (technical seo) אשמח לסייע לכם בכך.